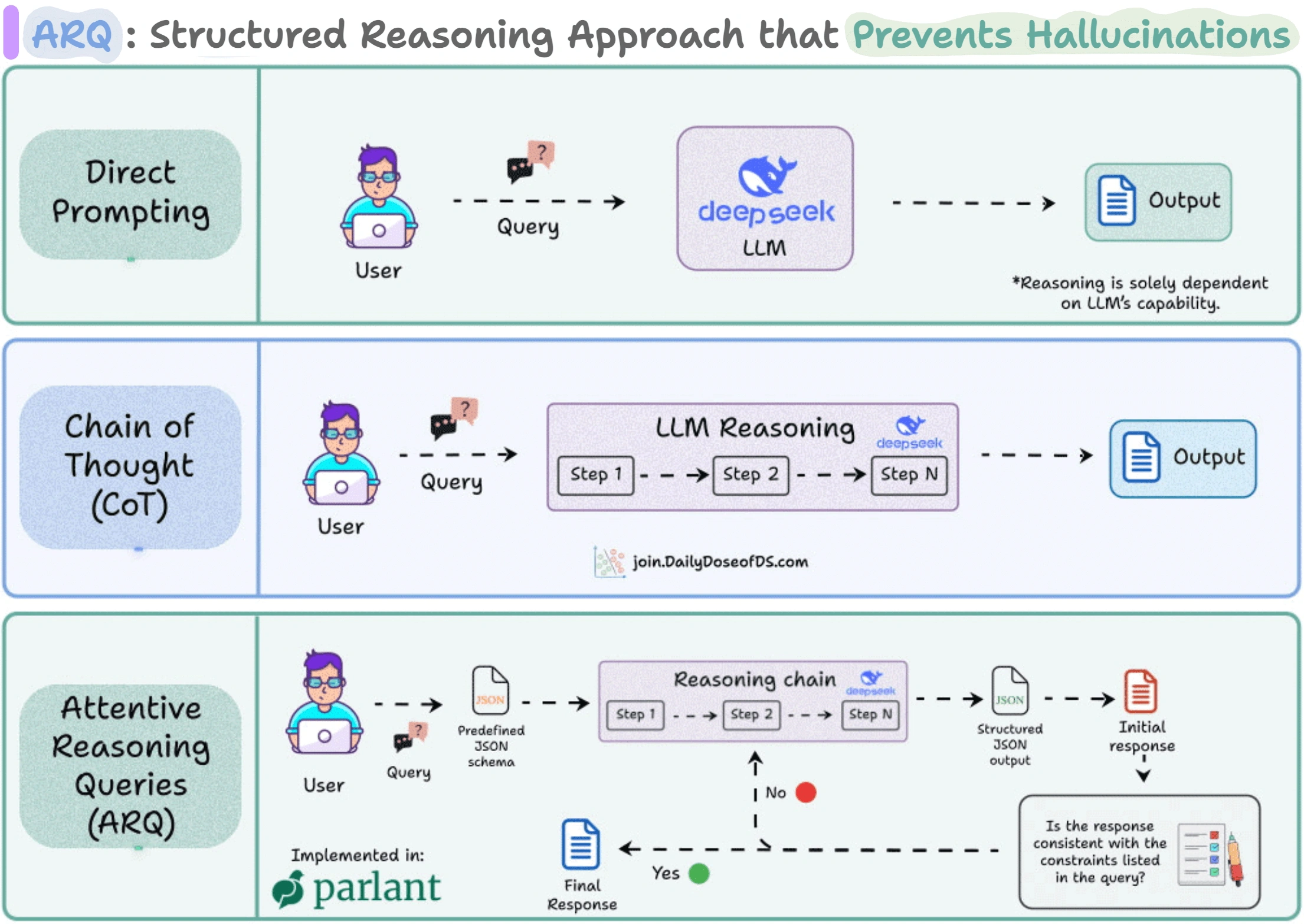

一个新的能够有效避免 LLM 产生幻觉的智能体框架 Parlant,它采用了一种新的,叫做注意力推理查询(Attentive Reasoning Queries, ARQ)的推理方式。开发者表示,这种新的方式,在各种测试场景下的准确率高达 90.2%,比现在流行的 Chain-of-Thought(思维链)还要靠谱。

我们在和大模型聊天时都会遇到这样的问题,一开始模型还能记住各种规则,但聊着聊着,它就会慢慢忘了初衷。比如你给它写了一大堆操作规范,明明说了 “绝不能主动承诺退款”,结果聊到后面,它还是可能直接许诺给客户退款。这个问题的根本原因是模型难以在长对话里持续关注关键的规则和上下文。

传统的思维链方法(CoT),虽然让模型 “分步思考”,但整个过程还是比较自由,缺乏强约束。ARQ 的思路完全不一样,它的每一步推理都被设计成 “有针对性的问题”,而且这些问题是写死在结构化模板(Json 格式的文本)里。举个例子,模型每一步都要明确回答,当前客户在问什么?相关的行为准则是什么?之前采取过哪些操作?接下来要不要调用外部工具?等等。这种方式可以反复强化最重要的规则,让推理过程变得可控、可查。

这样,模型最终的输出就不会是一堆天马行空的内容,而是走完一条有明确节点、有约束、能追溯的推理流程。开发团队的数据测试现实,ARQ 的表现确实比传统做法更稳,尤其在涉及复杂流程和多轮对话时,表现非常突出。

这个方法已经被集成进 Parlant 这个很火的开源项目里了,现在很多人都在用。ARQ 主要用在三个环节:挑选适用的行为规则、判断是否需要调用外部工具,以及最终生成对客户的回复。

归根结底,一个重要启示就是:让推理过程结构化、可量化、和实际业务贴合,模型就不容易胡说八道。自由发挥听起来很强大,但在要求严谨、流程复杂的场景里,结构化的推理方式才是真正靠谱的选择。