今天,阿里巴巴发布了备受瞩目的通义千问3(Qwen3)系列模型,以其卓越的性能和开源策略迅速登顶全球开源大模型王座。这一发布不仅标志着中国 AI 技术在全球范围内的领先地位,也为开发者、研究者和企业提供了全新的工具和可能性。Qwen3 以其混合推理模式、多语言支持、智能体能力以及高效的 MoE 架构,展现了技术创新与实用性的结合。

技术架构:混合推理与 MoE 架构的创新融合

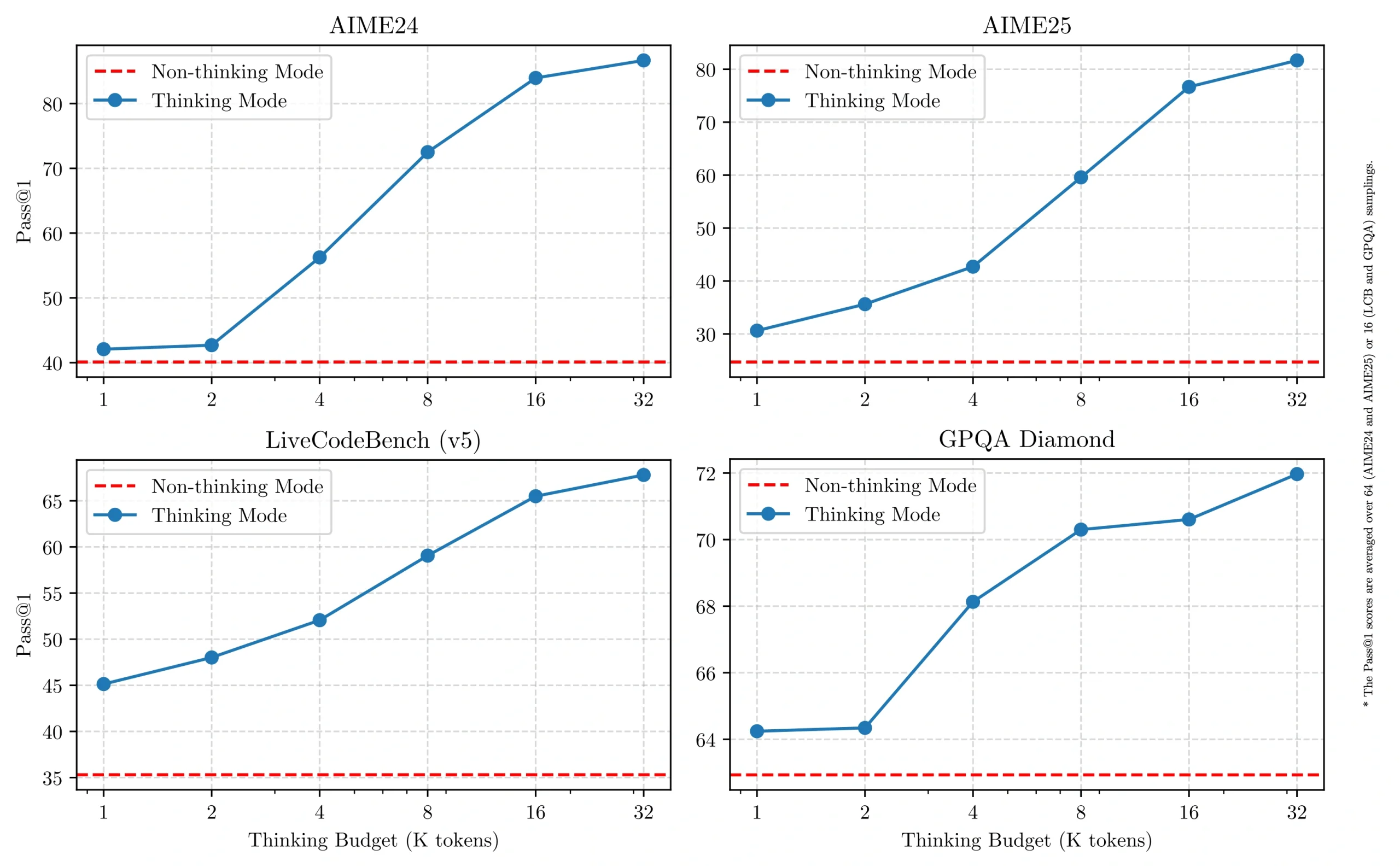

Qwen3 系列最引人注目的技术突破在于其 “混合推理模式” 的设计,这一模式将 “快思考”(非思考模式)和 “慢思考”(思考模式)集成于同一个模型中。对于简单问题,模型能够在低算力条件下实现 “秒回” 响应。而面对复杂的逻辑推理、数学计算或编码任务,模型则会进入深度思考模式,逐步推理并输出精准答案。这种灵活性使得 Qwen3 能够根据任务需求动态调整计算资源,从而在性能与成本之间实现高效平衡。用户甚至可以通过 API 设置 “思考预算”,即指定最大深度思考的 Token 数量,进一步优化资源分配。

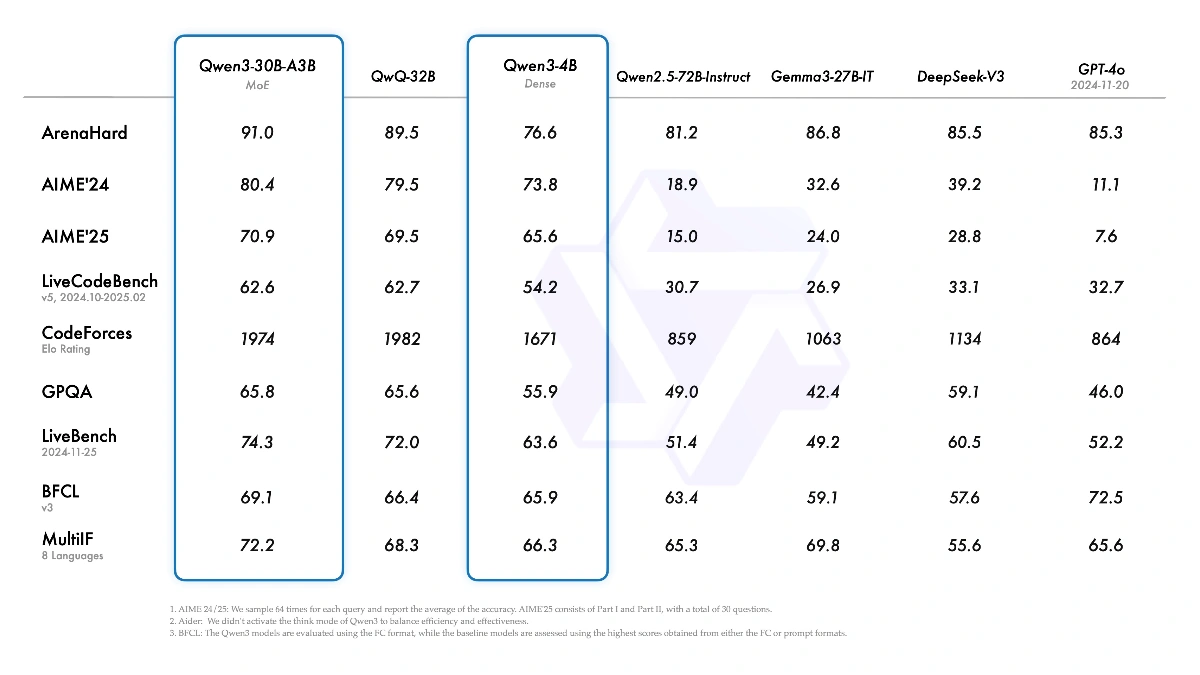

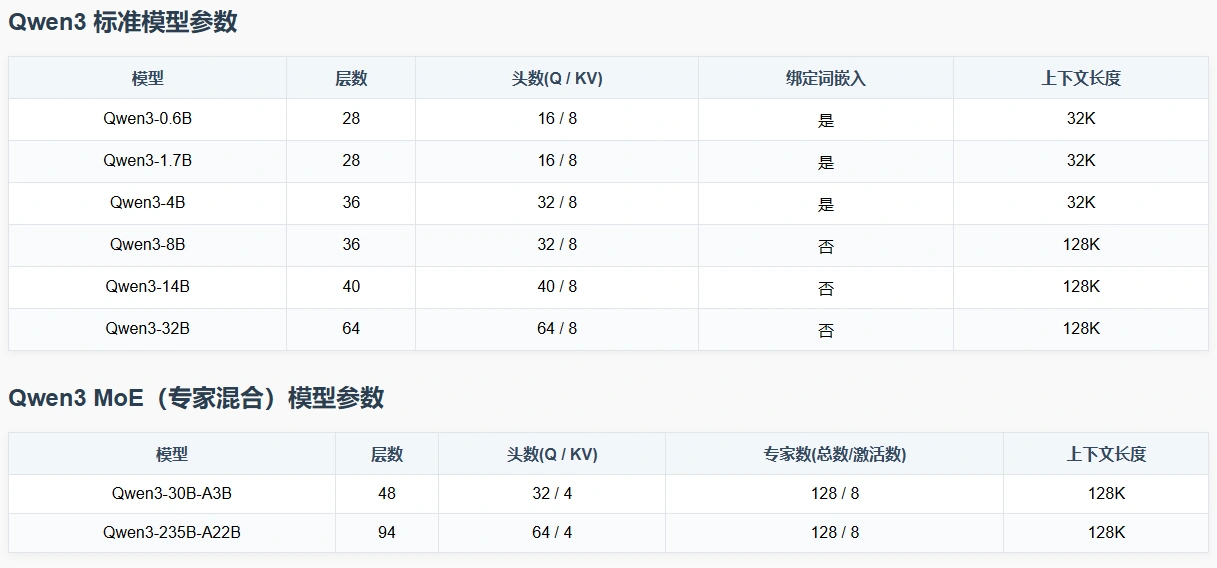

在模型架构层面,Qwen3 采用了混合专家(MoE)架构,旗舰模型 Qwen3-235B-A22B 拥有 2350 亿总参数,但激活参数仅为220 亿。这种设计大幅降低了计算成本,同时保持了高性能。相比之下,Qwen3-30B-A3B 模型仅激活30 亿参数,却能媲美上一代 Qwen2.5-32B 的性能,展现了 MoE 架构在效率上的显著优势。此外,Qwen3 还包括一系列稠密模型,参数规模从 0.6B 到 32B 不等,覆盖了从手机端到企业级服务器的多样化部署需求。例如,4B 模型被认为是手机端的理想选择,而 32B 模型则受到企业大规模部署的青睐。

训练数据与流程:规模与质量的平衡

Qwen3 的卓越性能离不开其背后庞大的训练数据和精巧的训练流程。相比前代 Qwen2.5 的 18 万亿 Token 训练数据,Qwen3 将数据集规模扩展至 36 万亿 Token,几乎翻倍。这一数据集不仅来源于网络,还包括从 PDF 等文档中提取的高质量文本内容。为了确保数据准确性,团队利用 Qwen2.5-VL 进行文本提取,并通过 Qwen2.5 优化内容质量。此外,针对数学和编码领域的专业需求,Qwen3 还引入了大量合成数据,由 Qwen2.5-Math 和Qwen2.5-Coder 生成,包括教科书、问答对和代码片段。

预训练过程分为三个阶段:

第一阶段(S1)以 4K 上下文长度为基础,使用超过 30 万亿 Token 构建通用语言能力和知识基础。

第二阶段(S2)增加 STEM、编码和推理任务的知识密集型数据比例,利用额外 5 万亿 Token 提升专业能力。

第三阶段(S3)则通过高质量长上下文数据,将模型上下文长度扩展至 32K 甚至 128K,确保其能够处理复杂长输入。这一多阶段训练策略使得 Qwen3 在不同任务场景下均表现出色。

后训练阶段同样令人印象深刻,Qwen3 设计了四阶段流程以打造混合推理能力:首先通过长思维链(CoT)数据冷启动,覆盖数学、编码和逻辑推理任务。随后利用强化学习(RL)扩展计算资源,结合规则奖励提升推理路径探索能力。第三阶段将快速响应能力融入深度推理模型,实现两种模式的无缝融合。最后在 20 多个通用领域任务中应用 RL,进一步增强模型的指令遵循和智能体能力,同时纠正不良行为。这种细致的分阶段优化确保了 Qwen3在复杂任务中的精准性和日常对话中的流畅性。

性能表现惊艳,基准测试超越国际顶尖模型

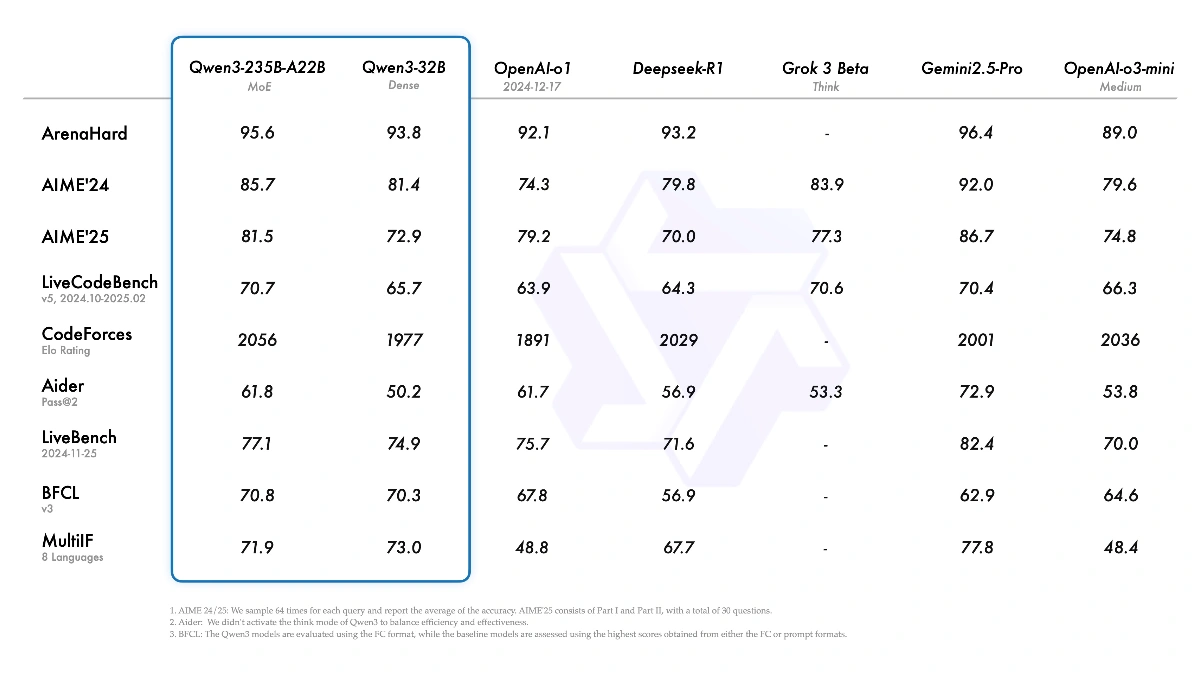

Qwen3 一经发布,便在多个基准测试中展现出惊艳表现,成为全球开源模型的新标杆。在奥数水平的 AIME25 测评中,Qwen3 取得 81.5 分,刷新开源纪录。在代码能力测试 LiveCodeBench 中,其得分突破 70 分,甚至超越 Grok3。在人类偏好对齐的 ArenaHard 评测中,Qwen3 以 95.6 分力压 OpenAI o1 和 DeepSeek-R1。尤其值得一提的是,Qwen3-235B-A22B 在编码、数学和通用能力等领域的表现,与 DeepSeek-R1、Gemini-2.5-Pro 等顶尖模型相比毫不逊色,而其参数量仅为 DeepSeek-R1 的三分之一,成本却大幅降低,仅需 4 张 H20 即可部署满血版,显存占用仅为同类模型的三分之一。

不仅旗舰模型表现出色,Qwen3 系列中的小型模型同样表现亮眼。例如,Qwen3-30B-A3B 仅激活 3 亿参数,却超越了 Qwen2.5-32B 的性能。而 Qwen3-4B 这样的轻量级模型,也能媲美 Qwen2.5-72B-Instruct 的表现。这种跨级别的性能突破,充分体现了 MoE 架构和训练优化的强大威力。此外,Qwen3 在多语言任务中的表现也堪称最佳,支持 119 种语言和方言,覆盖了印欧语系、汉藏语系、非洲-亚洲语系等多个语族,在 MGSM 和 MMMLU 等测试中超越了 DeepSeek-V3 和 Qwen2.5。

开源生态,赋能全球开发者与企业

Qwen3 的发布不仅是一次技术突破,对全球 AI 生态也具有深远贡献。阿里通义团队将 Qwen3 全系列 8 款模型(包括 2 款 MoE 模型和 6 款稠密模型)以Apache 2.0 许可完全开源,允许免费商用。这一策略使得全球开发者、研究机构和企业能够无门槛获取顶尖 AI 技术,推动创新应用的爆发。截至目前,阿里通义已开源超过 200 个模型,全球下载量突破 3 亿次,衍生模型数超过 10 万,全面超越美国的 Llama 模型家族,成为全球第一开源模型家族。

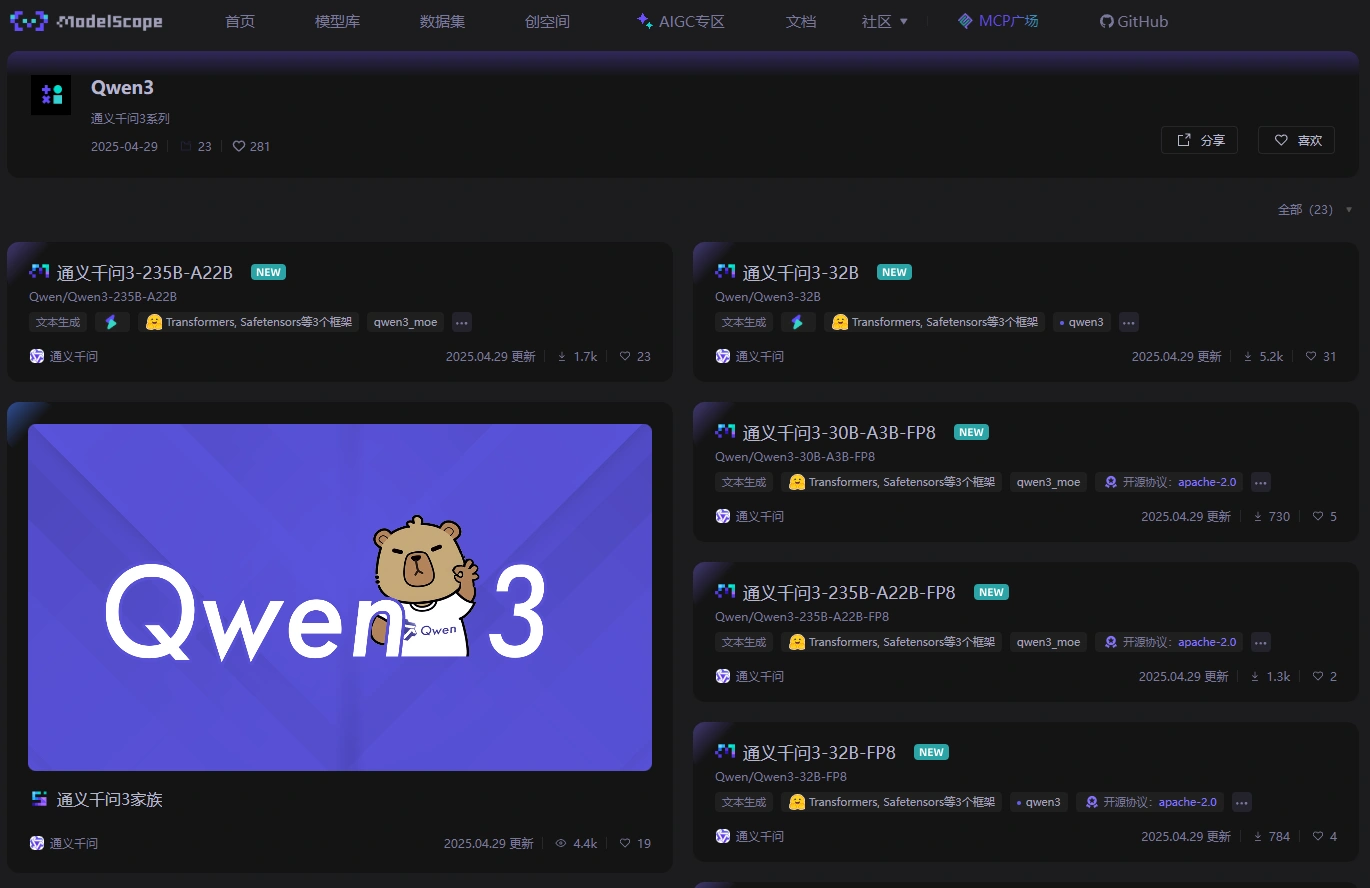

为了方便用户使用,Qwen3 已在多个平台上线,包括 Hugging Face、魔塔社区(ModelScope)、GitHub , 和 Kaggle,同时支持通过阿里云百炼调用 API 服务。

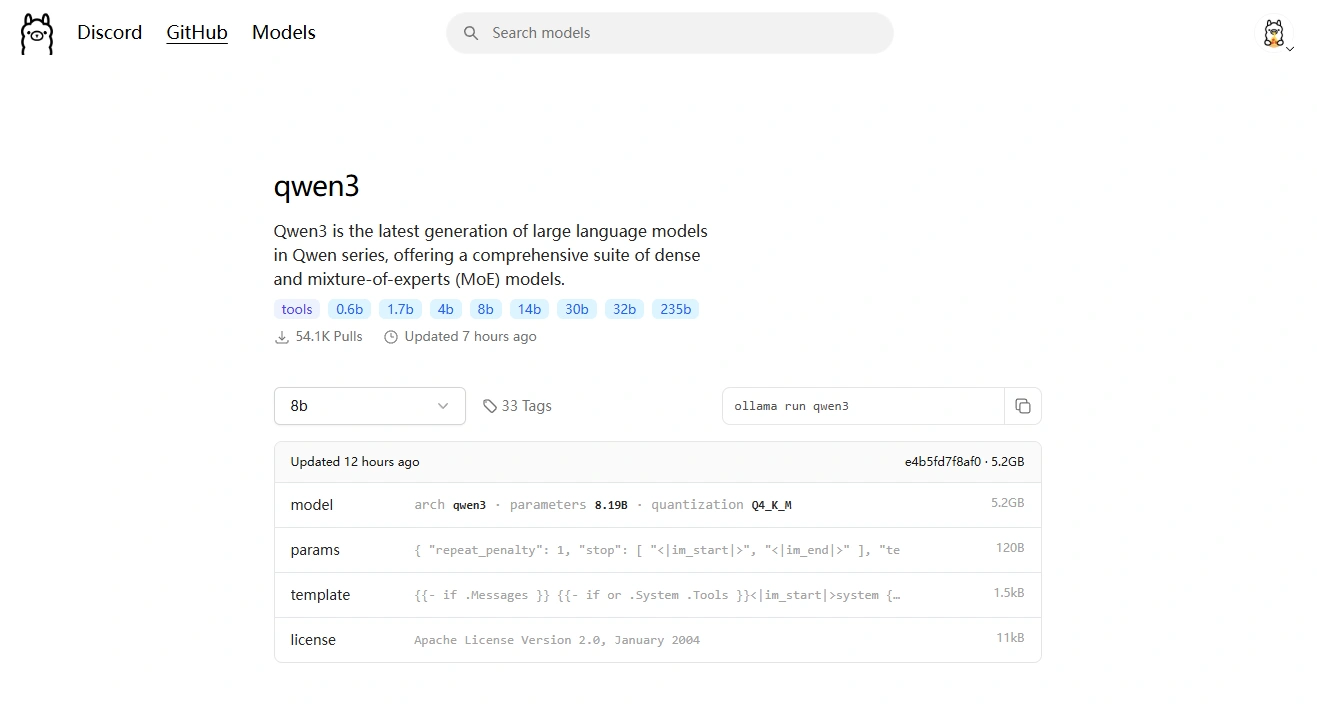

个人用户可通过通义 APP 或 Qwen Chat(chat.qwen.ai)直接体验,而开发者则可以利用 SGLang、vLLM 等框架进行部署,或借助 Ollama、LMStudio、llama.cpp 等工具实现本地运行。值得一提的是,Qwen3 在硬件兼容性上也表现出色,苹果工程师 Awni Hannun 表示,其已在 MLX 框架支持下实现本地运行,iPhone 可运行 0.6B 和 4B 模型,M2 Ultra 设备运行 Qwen3-235B MoE 模型时生成速度高达 28 Token/s。这种广泛的硬件适配性,进一步降低了技术应用的门槛。

应用场景与智能体能力

Qwen3 在智能体(Agent)能力上的优化,为 AI 应用的大规模落地奠定了基础。在 BFCL 评测中,Qwen3 以70.8 分超越 Gemini 2.5-Pro 和 OpenAI o1,展现了其在复杂基于智能体任务中的领先性能。其原生支持 MCP 协议,并结合 Qwen-Agent 框架封装工具调用模板和解析器,大幅降低了编码复杂性,使得开发者能够轻松实现手机、电脑端的智能体操作。这一特性对于即将到来的智能体应用爆发具有重要意义。

从更广泛的应用场景来看,Qwen3 的多语言支持和高效推理能力,使其在国际市场具有巨大潜力。支持 119 种语言和方言的特性,不仅适用于多语言指令跟随和翻译任务,也为创建全球化的 AI 应用提供了可能。无论是教育领域的个性化辅导、企业的智能客服,还是创意写作和角色扮演等场景,Qwen3 都能凭借其自然流畅的对话体验和深度推理能力,提供高质量服务。

对于未来发展,通义千问团队已明确表示将进一步扩展模型规模、上下文长度和多模态能力,同时通过环境反馈强化学习推进长距离推理能力。这种从 “训练模型” 向 “训练智能体” 的转变,或许预示着 AI 发展的新方向。Qwen3 作为通向通用人工智能(AGI)和超级人工智能(ASI)的重要里程碑,其技术积累和生态影响无疑将深刻塑造 AI 的未来格局。