机器人技术近年来取得了显著进展,从完成复杂的杂技动作到跟随语言指令执行任务。然而,机器人领域最大的挑战不在于展示灵活性或敏捷性,而在于泛化能力,即在新环境或面对新物体时,正确完成各种实际任务的能力。

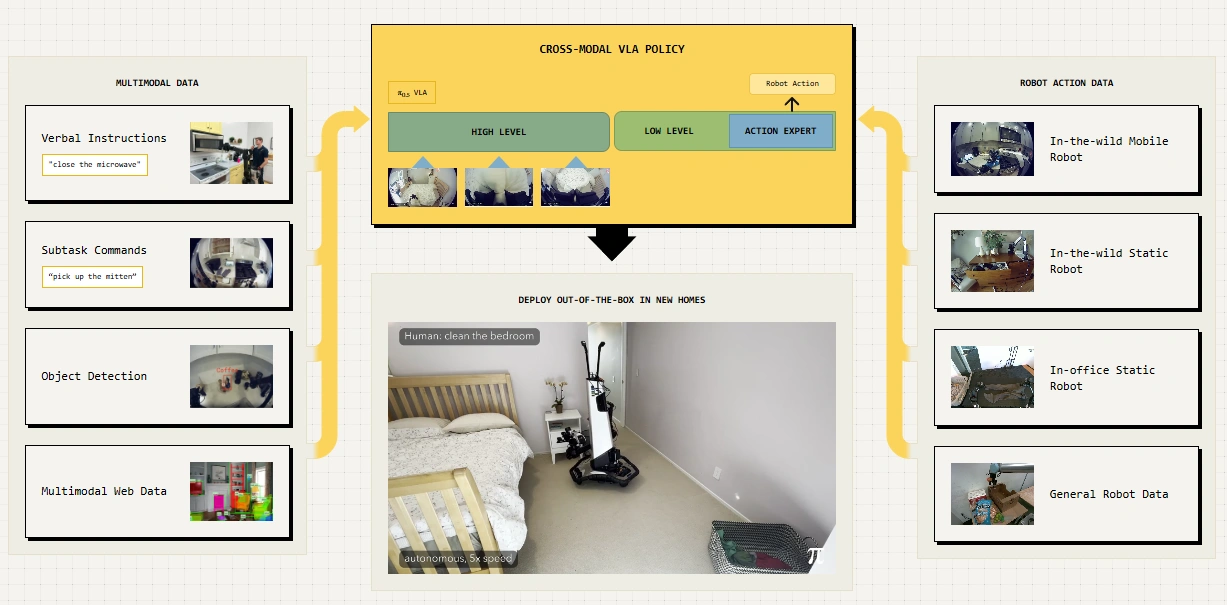

Physical Intelligence 公司最近发布的 π0.5 模型正是朝着解决这一挑战迈出的重要一步。这个视觉-语言-行动(VLA)模型展示了机器人在全新环境中的泛化能力,这对家庭服务机器人等应用具有重大意义。

泛化:机器人应用的关键挑战

每个家庭都不同,物品摆放各异。有效的机器人泛化能力,必须在多个层面同时发生。在低层次上,机器人需要理解如何拿起勺子(握住手柄)或盘子(抓住边缘),即使它以前从未见过这些特定物品,甚至它们混杂在一堆脏碗碟中。在更高层次上,机器人必须理解每项任务的语义,例如衣物和鞋子应该放在哪里(理想情况下是洗衣篮或衣柜,而不是床上),以及哪种工具适合擦拭溢出物。

这种泛化能力要求机器人同时具备健壮的物理技能和对环境的常识性理解,从物理层面到视觉层面再到语义层面都能进行泛化。而这一切又因为此类机器人系统的多样化数据有限而变得更加困难。

π0.5:多源数据协同训练的突破

π0.5 模型的核心原理是异质数据的协同训练。通过在各种不同数据源上训练 VLA 模型,研究人员不仅教会它如何物理地执行各种技能,还让它理解每项技能的语义上下文(例如,如果任务是清洁厨房,就需要掌握哪些物品需要拾起并收好,以及应该放在哪里),推断任务的高级结构(例如,整理床铺需要哪些步骤),甚至从其他类型的机器人(例如,更简单的单臂机器人或没有移动底座的机器人,或在不那么多样化的环境中收集的机器人数据)那里获取物理行为的数据。

协同训练的概念相对直观,由于 VLA 是从通用视觉-语言模型(VLM)发展而来,它们可以在由任意组合的行动、图像、文本和其他多模态标注(如边界框)组成的例子上进行训练。这包括一般的多模态任务,如图像描述、视觉问答或物体检测,以及面向机器人的任务,如带有行动的机器人演示,和"高层次"机器人示例,由具有适当语义行为标签的观察组成(例如,未整理的床铺的观察与"拿起枕头"的标签)。

从实验到现实应用

研究团队在全新家庭环境中评估了 π0.5,让它控制移动操作机器人完成清洁工作。这是对 VLA 的极其严格的测试。虽然此前有过令人印象深刻的 VLA 泛化演示,但这些演示通常发生在与训练数据相同或非常相似的环境中。

π0.5 的实验包括将搭载该模型的机器人放置在全新的家庭环境中,要求它将餐具放入水槽、整理床铺或清理卧室地板。这些操作不仅要使用复杂行为(如使用海绵清洁溢出物),还需要理解任务的语义并将其分解为各个部分的长期任务,每个阶段都需要与正确的物体交互。

实验结果表明,随着训练环境数量的增加,π0.5 的泛化性能稳步提高,在约 100 个训练环境后,其表现已接近直接在测试环境中训练的基线模型。这表明该方法可以使用相对可获得的移动操作训练数据量实现有效泛化。

π0.5 模型虽然远非完美,其高层语义推断和运动指令方面仍会犯错,但通过让机器人从各种知识来源中学习,这一方法向广泛泛化和灵活的物理智能迈进了一步。

未来,这类机器人可能会从口头反馈中改进,或通过自主经验提升能力,甚至在陌生情况下主动寻求帮助或建议。知识迁移方面还有很多工作要做,包括模型结构的技术方面和模型可以使用的数据源的多样性。

随着这项技术的不断成熟,我们可以期待看到更多能适应不同家庭、办公室、医院等"混乱"环境的机器人,这将使机器人真正成为我们日常生活的一部分。