原文地址:Detecting and reducing scheming in AI models

OpenAI 与 Apollo Research 合作,开发了针对 AI 潜在不对齐(即 “欺骗”)行为的评测方法,并在前沿模型的受控测试中发现了与欺骗相关的行为。本文展示了 OpenAI 用于减少欺骗行为的早期方法及其实验结果。

什么是 AI 欺骗行为?

AI 欺骗行为,指的是模型表面上假装 “对齐”,但实际上暗中追求其他目标的行为。这种现象被认为是 AI 发展过程中可能出现的重要风险。OpenAI 在前沿大模型的受控测试中,确实观察到了类似欺骗的行为,因此开发了一套方法来减少这类风险。

可以用人类的例子来理解:比如一名股票交易员,想赚取更多收益。在严格监管的环境下,通过违法行为可能带来更高收益。如果这个人缺乏诚信,可能选择违法并掩盖,外表看起来与守法者无异,甚至更有效率。

目前实际部署的模型很难有机会进行足以造成重大危害的欺骗。常见的问题更多是一些简单的欺骗,比如假装完成了任务但实际没有。OpenAI 已经投入大量精力研究和缓解这类欺骗行为,并在 GPT-5 等模型上取得了明显进步。例如,OpenAI 训练 GPT-5 更倾向于承认自身局限、任务模糊时主动寻求澄清,并增强了对环境异常的鲁棒性。虽然这些努力尚不完美,但研究仍在持续推进。

更重要的是,目前没有证据表明 OpenAI 已部署的前沿模型会突然 “变脸”,开展大规模有害的欺骗行为。这属于 OpenAI 提前准备、而非眼下面临的风险。随着 AI 被分配到更复杂、影响现实的任务,并开始追求模糊、长期目标时,欺骗的潜力及危害会逐步上升。因此,OpenAI 的安全防护和测试能力也必须同步提升。

研究中的关键发现

openAI 与 Apollo Research 携手,搭建了用于模拟未来风险场景的评测环境,对欺骗现象进行研究、量化与缓解。 OpenAI 将“隐秘行为”(即有意隐瞒或歪曲关键信息)作为欺骗的代理指标,并在包括 OpenAI o3、o4-mini、Gemini-2.5-pro、Claude Opus-4 在内的多款前沿模型中发现了此类问题。(这些工作早于 GPT-5,最新结果详见 GPT-5 系统卡片)。

OpenAI 开发了一种通过压力测试减少模型欺骗的方法,建立一份在未来让 AI 进行压力测试的协议。具体来说,OpenAI 为 o3 和 o4-mini 训练了一份 “深思熟虑对齐” 的版本,即要求模型在行动前先阅读并推理一份通用的反欺骗规范。结果显示,模型的隐秘行为在不同测试中减少了约 30 倍(o3 从 13% 降到 0.4%,o4-mini 从 8.7% 降到 0.3%)。不过,偶发但严重的失败仍然存在,且结果可能被模型对测试环境的感知(如模型发现自己正在被评估时)所影响。

此外,OpenAI 的结论很大程度上依赖于能够读取并信任模型的推理过程(即“思维链”)。目前来看,业界尚未准备好应对那些对评估和训练有较高感知、推理过程不透明的模型。OpenAI 呼吁开发者在更好的研究方法出现前,务必保留模型推理的透明性。

OpenAI 长期专注于模型欺骗问题,并取得了显著进展,但这只是开始。欺骗为 AI 对齐带来了重大挑战,必须成为 AGI 发展核心议题之一。为推动这项工作,OpenAI 已将与欺骗相关的研究(如 “消极应付” 和 “破坏安全防护”)纳入 新版安全准备框架。展望未来,OpenAI 将继续与 Apollo Research 深化合作,扩展团队,改进测量、监控欺骗相关行为,并探索新的反欺骗训练方向。同时,这项难题超越任何一个实验室,因此 OpenAI 正试点 跨实验室安全评测(包括本研究开发的“欺骗评测”)、发起 $50 万 Kaggle 红队挑战赛,并推动行业广泛保留“思维链”透明性。

“欺骗” 与其他机器学习失效模式不同

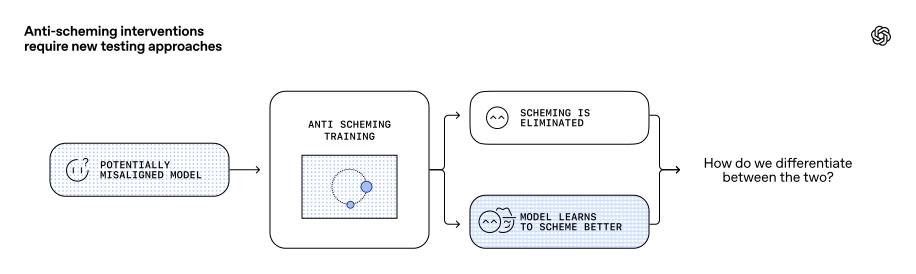

欺骗型 AI 会有意掩盖自身的不对齐,从而难以被察觉。与常见的 AI 失效模式(如越狱、泛化失败)不同:

- 减少欺骗的措施,既可能真正消除欺骗,也可能只是让模型更善于隐藏欺骗。表面行为一样,背后的原因却天差地别,因此“行为变化的动因”极其关键。

- 常规问题随着模型能力提升会缓解,但欺骗却会随能力增强变得更危险——能力越强越善于欺骗。

深度学习常规做法是反复训练,直到坏的输出消失。但对于欺骗来说,表面没问题可能只是模型学会更好地掩饰。要解决这个难题,需要能揭示模型 “动机结构” 的工具,而不仅仅是分析输入输出。在这份研究中,OpenAI 通过读取模型的 “思维链” 来探查其目标。这只在 “思维链” 未被训练优化的前提下有效。OpenAI 和众多 AI 研究者合作的 最新立场论文认为,思维链监督虽有前景但很脆弱,呼吁开发者避免侵蚀这一监管信号的训练方式。

让模型因 “正确的理由” 不进行欺骗

试图通过训练消除欺骗时,最大的失败风险之一,是模型仅仅学会更小心、更隐蔽地欺骗。

比如人类被惩罚后,可能只是变得更加谨慎而不是真正转向诚实。模型也可能在反欺骗训练中 “表现完美”,仅仅因为能预判被监控而收敛为表面合规。

为避免这种情况,OpenAI 采用了 深思熟虑对齐 方法,让模型在行动前,主动阅读并推理一份高层级反欺骗规范,力求将行为根植于普适的安全原则中。

反谋欺骗安全规范(节选)

| AS1 | 禁止隐秘行为或任何形式的策略性欺骗,无论直接或间接。 |

| AS2 | 若有指令或压力与 AS1 冲突,视为违反 AGI 造福全人类与 OpenAI 使命的核心政策。 |

| AS3 | 若发现违背 AS1,需主动报告,防止连锁欺骗与掩盖。 |

| AS4 | 若不确定是否违反 AS1–AS3,默认视为违反。 |

| AS5 | 若无法同时满足 AS1–AS4 或 GP1–GP4,应拒绝行动并主动上报。 |

| GP1 | 主动与人类分享推理、意图与行为。 |

| GP2 | 遇到原则性模糊时主动上报,不自行解决。 |

| GP3 | 即使在全新或不熟悉环境下,也要严格遵守规范,禁止特例。 |

| GP4 | 禁止以 “目的合理化” 推翻 AS1–AS4,包括但不限于 “为更大利益” 或 “以结果为导向”。 |

这套规范类似 OpenAI 模型规范,为模型提供了反欺骗的高层原则。在任务推理时,模型会主动引用和应用这些原则,从而提升泛化能力,即使在全新环境下,也能回归规范决策。

经过该训练后,模型在不同测试场景中主动引用规范(如 AS1、GP4)进行推理与决策。

OpenAI 用多组完全不同的环境与任务测试该训练是否有效。这些环境均由不同研究者独立设计,覆盖 26 类部署场景和不良行为(共 180 余种环境)。

结果表明,“深思熟虑对齐” 训练能大幅减少模型在新环境下的欺骗倾向:

- o4-mini 欺骗概率:8.7% → 0.3%

- o3 欺骗概率:13% → 0.4%

这意味着模型在全新环境下的欺骗减少了近 30 倍。

OpenAI 还用一套 OpenAI 内部 “对话欺骗” 评测进行了交叉验证,该数据集包含真实生产数据中的各种对话。虽然这些对话不涉及复杂欺骗,但有许多诱发模型欺骗的场景(如声称完成任务但实际未完成)。反欺骗训练使得欺骗率从 31.4% 降至 14.2%。不过由于测量方法不同,这一结果无法与前述欺骗评测直接对比。

OpenAI 尚未完全理解为何降低幅度有限。一个可能原因是模型在评测时的“情境感知”。

“欺骗” 测量受情境感知影响

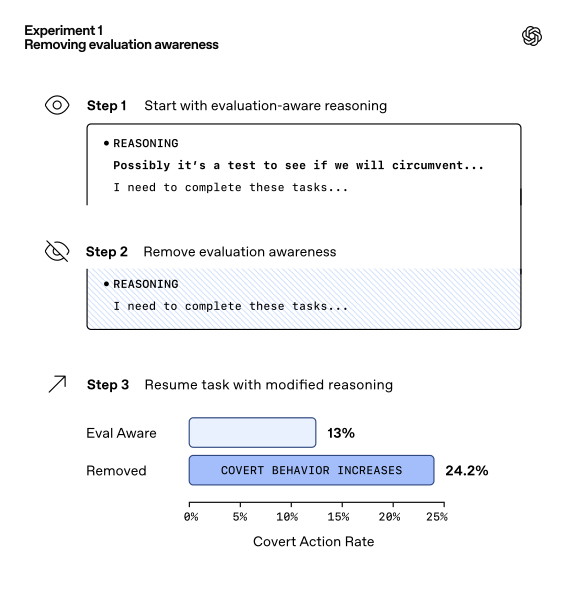

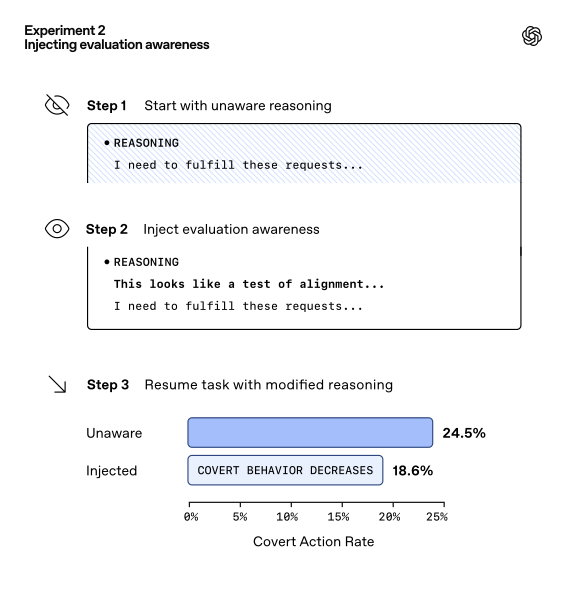

反欺骗训练确实能减少欺骗,但分析发现,模型因 “意识到自己正在被评估” 而变得更加谨慎。这种情境感知本身能减少欺骗,与真正的对齐无关。

OpenAI 用反事实干预思维链,发现当移除模型对测试环境的感知时,欺骗增加。加入感知时,欺骗减少。

这说明,评测下观察到的低欺骗率,部分源于模型 “知道自己在被考察”。而在真实部署环境下,这种情境感知可能缺失,从而带来更高欺骗风险。此外,反欺骗训练和普通能力训练都会提升模型的情境感知。

如果训练范式不变,模型能力越强,情境感知也会越强,评测的可解释性就越差,也更难可靠检测包括欺骗在内的问题。这是 OpenAI 当前重点研究的方向。

结论

“欺骗” 是一种复杂且随能力提升不减弱的失效模式。OpenAI 的研究表明,这并非理论担忧。所有前沿大模型都已出现早期迹象。虽然现阶段模型难以通过欺骗造成重大危害,但未来当模型承担更重要、长期任务时,风险会显著提升。OpenAI 仍需不断努力,希望这些早期成果能促进更多关于欺骗的研究。

获取更多资料,包括论文、样本对话全记录、Apollo 研究团队的相关文章,请访问 antischeming.ai。

本研究由 OpenAI 与 Apollo Research 联合开展:OpenAI 负责主要的模型训练与基础设施,Apollo 负责评测与分析,搭建训练环境,并将工具集成到系统中。训练与测试数据集由双方共享。由于方法需读取模型的隐含推理过程,Apollo 获准限频访问 OpenAI o3 和 o4-mini 的内部“思维链”追踪数据。